-

3D Gaussian Splatting for Real-Time Radiance Field RenderingAI/Vision 2024. 11. 25. 18:09

SIGGRAPH 2023

3D Gaussian Splatting for Real-Time Radiance Field Rendering

Bernhard Kerbl Georgios Kopanas Thomas Leimkühler George Drettakis

본 논문은 새로운 3D scene 생성 방법을 제시하는 논문이다. 기존 NeRF 보다 빠르고 더 좋은 화질의 3D scene을 생성할 수 있기 때문에 많은 주목을 받았던 논문이며, 해당 방법을 활용한 후속연구들이 활발히 이루어지고 있다.

Porject: https://repo-sam.inria.fr/fungraph/3d-gaussian-splatting/

3D Gaussian Splatting for Real-Time Radiance Field Rendering

[Müller 2022] Müller, T., Evans, A., Schied, C. and Keller, A., 2022. Instant neural graphics primitives with a multiresolution hash encoding [Hedman 2018] Hedman, P., Philip, J., Price, T., Frahm, J.M., Drettakis, G. and Brostow, G., 2018. Deep blending

repo-sam.inria.fr

0. Background

0.1 Rasterization vs Ray-marching

기존 3D representation 은 mesh와 point가 있다. 이는 3d 공강을 explicit 하게 표현하는 것으로 GPU/CUDA 기반의 빠른 rasterization(3D object를 2D pixel screen으로 display)에 잘 맞기 때문에 활발하게 연구되었다.

Rasterization 기반 방법들은 각 point를 최대한 한꺼번에 작업하려고 하기 때문에 속도가 빠른다는 장점을 가지고 있지만, 이 pixel 끼리 독립적으로 연산 수행이 되므로 투명한 물체나 겹치는 부분들을 표현할 수 없다는 단점이 존재한다.

출처: https://velog.io/@shj4901/3D-Gaussian-Splatting-for-Real-Time-Radiance-Field-Rendering-%EB%A6%AC%EB%B7%B0 NeRF는 3D scene을 continuous scene으로 표현하였으며, volumetric ray-marching을 활용하여 MLP를 학습하므로 3D 공간을 implicit 하게 표현하였다. NeRF는 기본적으로 pysics 기반의 방법으로, 현실에서 비친 ray를 통해 눈에 상이 맺히는 과정을 묘사하여 3D scene을 최적화한다. 특히, continuous representation의 가정은 이러한 최적화에 큰 도움이 된다고 한다.

출처: https://velog.io/@gjghks950/3D-Gaussian-Splatting-%EC%99%84%EB%B2%BD-%EB%B6%84%EC%84%9D-feat.-CUDA-Rasterizer

1. Introduction

(1) 일반적인 3D scene represenations 는 meshes and points이다. 이러한 표현 방법들은 explicit 하고, GPU/CUDA 기반 빠른 rasterization에 적합하다는 장점이 있다.

(2) 최근 제안된 NeRF는 연속적인 장면 표현을 기반으로하여, 일반적으로 캡처된 장면이 새로운 view 생성을 위해 volumetric rat-marching을 사용하여 MLP를 최적화한다. 이때 현재까지 가장 효율적인 radiance field solution은 voxel, hash grid or points에 저장된 값을 interpolation 하여 연속적인 표현을 기반으로 구축된다. 이러한 연속적인 접근 방식은 최적화에 도움을 주지만, rendering 필요한 stochastic sampling이 비용이 많이 들고 노이즈를 초래할 수 있다는 단점이 존재한다.

본 논문은 이 두가지 접근 방식의 장점을 결합한 새로운 방법을 제안한다. 3D gaussian representation은 SOTA 수준의 visual quality와 traninig time을 제공하며, tile-based splatting solution을 통해 1080p 해당도로 SOTA 품질의 real-time rendering을 보장한다.

본 논문의 목표는 여러 사진으로 캡쳐된 장면을 실시간으로 rendering 할 수 있도록 하고, 일반적인 실제 장면에 대해 이전의 가장 효율적인 방법과 비슷한 속도로 최적화 시간을 가지는 표현을 만드는 것이다.

기존의 NeRF는 고화질의 결과를 얻을 수 있지만 48시간의 학습시간을 필요로 하거나, 실시간 rendering이 가능하지만 품질이 낮은 readiance field 방법들이 존재한다.

본 논문의 solution은 아래의 세 가지 주요 구성 요소를 기반으로 한다.

1) 3D Gaussian

먼저 유연하고 표현력이 풍부한 scene representation으로 3D Gaussian을 소개한다. 이전 NeRF와 유사한 방법, structure-from-motion (SfM)으로 보정된 카메라와 동일한 입력으로 시작하며, SfM process에서 생성되는 sparse point cloud를 사용해서 3D Gaussian set을 초기화한다. 대부분의 point based solution이 multi view stereo (MVS) 데이터를 필요로 하는 것과 달리, SfM만으로 높은 성능을 달성할 수 있다. 3D Gaussian 은 미분 가능한 volmetric represetation으로 우수한 선택이다. 기존 NeRF와 동등한 image formation model을 사용하여 표준 α-blending을 적용하여 매우 효율적으로 rasterization 할 수도 있다.

2) 3D Gaussina의 최적화

3d 위치, opacity α, anisotropic covariance, 구면 조화 (SH) 계수와 같은 3D Gaussian의 속성을 최적화하는 것이다. Adaptive density control step과 interleaved 되어 최적화하는 동안, 3D Gaussain을 추가하거나 때때로 제거한다. 이를 통해, 장면을 효율적이고 정밀하게 표현할 수 있으며, 모든 장면에서 1~5만개의 gaussian 만으로 표현 가능하다.

3) Tile-based rasterization

빠른 GPU 정렬 알고리즘을 사용하는 real-time rendering solution으로, tile-based rasterization 방식을 따른다. 그러나 이들의 3D Gaussian representatino 덕분에, 가시성 순서를 준수하는 이방성 스플래팅을 수행할 수 있다. 이는 정렬 및 α-blending을 통해 이루어지며, 필요한 만큼 정렬된 splats 탐색 과정을 추적함으로써 빠르고 정확한 backward pass를 가능하게 한다.

2. Overview

1) SfM는 부수적인 sparse point cloud 를 생한다. 본 논문에서는 이 point cloud를 기반으로 3D Gaussian set을 생성한다. 3D Gaussian은 3d position (mean), covariance matrix, and opacity α로 정의되며, 매우 유연한 최적화 환경을 제공한다. Highly anisotropic volumnetric splats를 이용하여 세부정보를 compact 하게 표현한다. 즉, 3d scene을 비교적 간결하게 표현한다.

Position (mean) 3D space에서 gaussian의 center point를 의미 Covariance Matrix Gaussian의 spread 를 의미하며, shape을 결정 Opacity α Gaussian의 투명도 결정

출처: https://dusruddl2.tistory.com/29 위와 같은 형태의 Gaussian을 여러개 붙이고 뭉쳐서 하나의 object를 만든다고 생각하면 이해하기 쉬울 것이다.

2) 3D Gaussian 의 파라미터 3d position (mean), covariance matrix, and opacity α 의 최적화 단계를 통해 radiance field representation을 생성하며, gaussian density의 adaptive control을 위한 연산과 교차되어 진행된다.

3) 본 논문의 효율성의 핵심은 Tile-based rasterizer로, 빠른 정렬 덕분에 가시성 순서를 준수하면서 이방성 스플랫의 α-blending 을 가능하게 한다. Fast rasterizer는 누적된 α 값을 추적하여 gradient를 받을 수 있는 gaussian의 개수에 제한 없이 빠른 역전파를 지원한다.

3. Differentiable 3D Gaussain Splatting

이들은 sparse set of points without normals 로부터 시작하여 고품질의 새로운 view synthesis를 가능하게 하는 scene representation을 최적화하는 것이 목표이다.

이를 수행하기 위해서 미분가능한 volumetric representation의 특성을 상속하면서도 매우 빠른 rendering을 가능하게 하는 비정형적이고 명시적인 primitive가 필요하다. 저자들은 이러한 primitive를 위해 3D Gaussian을 채택했다. 3D Gaussian은 미분가능하고 쉽게 2D projection이 가능하여 α-blending을 이용한 빠른 rendering이 가능하다.

이전 방법들은 이떤 planar circle과 normal vector로 2D point를 모델링한다. 이는 2D point modeling에서 사용하는 방법으로 각각의 point를 normal을 갖는 작은 평면 원으로 가정하는 연구이다.

출처: https://dusruddl2.tistory.com/29 중심점 3D 점의 위치 법선 벡터 원의 방향 정의, 법선은 표면의 기울기를 의미한다. 이때, 표면의 기울기는 옷깃의 접힘, 차량 전면의 곡면등을 의미한다. 반지름 원의 크기를 정하며, 장면의 스케일에 따라 결정된다. 이들이 얻은 SfM point 표현 방식은 2D point를 사용하는 이전 연구와 유사하여, 위와 같이 각 point를 planar circler로 가정하여 문제를 풀고자 하였다. 그러나, SfM point의 extreme sparsity 때문에 normal을 estimate 하는 것이 매우 어렵다.이를 해결하기 위해서, normal을 요구하지 않는 3D gaussain set으로 geometry를 modeling 한다.

이들의 gaussian은 world space에서 정의된 3D covariance matrix (공분산 행렬) Σ와 포인트(평균) 𝜇를 중심으로 정의됩니다:

3D Gaussian은 normal vector를 필요로 하지 않아, sparse 한 SfM point에서 구하기 어려운 normal estimate를 하지 않아도 된다.

Gaussian 위의 gaussian은 blending 과정에서 α 로 곱해진다.

그러나 rendering을 위해서는 3D Gaussian을 2D로 projection 해야 한다. Viewing transformation W( world 좌표계에서 camera 좌표계로 바꿔주는 viewing transformation)가 주어지면 카메라 좌표의 convariance 행렬 Σ'은 아래와 같다.

카메라 좌표의 convariance 행렬 J는 projective transformation의 affine approximation의 Jacobian이다.

이제 공분산 행렬 Σ을 직접적으로 optimize 하면 radiance field를 나타내는 3D Gaussian을 얻을 수 있다. 하지만, covariance matrix는 positive semi-definite(양의 준정부호)한 행렬일 경우에만 물리적으로 의미가 있다. Positive semi-definite는 행렬의 이차형식이 양수/0/음수 중 어떤 부호를 가지는지에 따라 결정되는 성질이다. 모든 parameters의 최적화를 위해 유효한 행렬을 생성하도록 쉽게 제한할 수 없는 gradient descent을 사용하며, 업데이트 단계와 경사는 매우 쉽게 유효하지 않은 공분산 행렬을 생성할 수 있다. 모델 학습 중에 covariance가 positive semi-definite인 상황에서는 cost function이 최솟값에 수렴하지만, 반대로 그렇지 않은 경우에는 학습이 불안정해질 수 있다.

그러므로, 본 저자들은 더 직관적이면서도 동등하게 표현력이 있는 최적화 표현을 선택하였다. 3D Gaussian의 covariance matrix Σ 는 타원체의 구성을 설명하는 것과 유사하다. 주어진 scaling matrix S와 roatate matrix R에 대해 아래와 같은 covariance matrix Σ 를 얻을 수 있다.

위 수식에서 S(S^T)는 타원체의 모양(축 길이)을 의미하며, R은 타원체 회전 방향을 의미한다.

이때, scaling과 rotation을 독립적으로 optimization 하여 covariance matrix가 유효하도록 만들어 주었다고 한다. 이때 scaling factor는 3D vector 로 저장되고, rotation은 quaternion 로 표현되어 저장된다.

학습 중 자동 미분으로 인한 상당한 overhead를 피하기 위해서 모든 parameters에 대한 gradients를 명시적으로 도출한다. 이러한 이방성 공분산 표현은 최적화에 적합하며, 캡처된 장면의 다양한 형상의 기하에 적응하도록 3D 가우시안을 최적화할 수 있게 하며, 비교적 압축된 표현을 제공합니다. 위 그림은 이러한 케이스를 보여준다.

4. Optimization with Adaptive Densitiy Control of 3D Gaussain

4.1 Optimization

최적화는 렌더링과 그 결과 이미지를 캡처된 데이터셋의 training view와 비교하는 연속적인 반복 과정을 기반으로 이루어진다. 3D to 2D projection에서 발생하는 모호성으로 인해 geometry가 잘못 배치될 가능성이 있다. 따라서 이들의 optimization 은 잘못 배 된 geometry를 생성, 제거, 또는 이동시킬 수 있어야 한다. 3D Gaussain의 covariance paramters의 품질은 소스의 large anisotropic(이방성) Gaussain을 사용하여 큰 homogeneous 영역을 캡처될 수 있기 때문에, 표현을 간결하게 하는데 중요하다.

이들은 optimization을 위해 sotchastic gradient descent (SGD)를 사용하며, 표준 GPU 가속 프레임워크와 일부 연산을 위해 사용자 정의 CUDA 커널을 추가할 수 있는 기능을 최대한 사용하였다. 특히, 최적화 과정에서 주요 computational bottleneck인 fast rasterization 은 최적화 효율성의 핵심요소라고 한다.

𝛼 값을 [0, 1) 범위로 제한하고 부드러운 gradient를 얻기 위해 sigmoid 활성화 함수를 사용하며, covariance의 scale에는 유사한 이유로 exponential 활성화 함수를 사용합니다. 초기 covariance matrix는 가장 가까운 세 포인트까지의 거리 평균을 축으로 하는 isotropic(등방성) Gaussain으로 추정합니다.

이들은 Plenoxels와 유사하게 위치에 대해서만 적용되는 standard exponential decay scheduling을 사용한다. 최종 손실함수는 L1와 D-SSIM term을 결합하여 아래 같이 정의된다:

test 전반에서 λ=0.2를 사용하였다고 한다.

4.2 Adaptive Control of Gaussians

이들은 SfM에서 얻은 초기 sparse points set으로 시작하여, gaussian의 개수와 단위 부피당 density를 adaptively control 하는 방법을 적용한다. 이를 통해 초기의 sparse gaussains set에서 scene을 더 잘 표현하고 올바른 매개변수를 가진 density가 높은 gaussians set으로 전환할 수 있다. Optimization warm-up이후, 매 100 interations 마다 gaussain을 밀집시키고, 𝛼 값이 임계값 ϵ_α보다 작은 사실상 투명한 가우시안을 제거한다.

Gaussian의 adaptively control 은 빈 영역을 채워야 한다. 이는 geometric features가 누락된 영역("under-reconsturction")과 장면에서 큰 영역을 차지하는 gaussian이 있는 영역("over-reconsturction") 모두를 대상으로 한다. 이들은 이러한 두 영역 모두 view space position gradients가 크게 나타난다는 점을 관찰했다고 한다. 직관적으로, 이는 이러한 영역이 아직 잘 복원되지 않았고, 최적화 과정에서 이를 수정하기 위해 Gaussian을 이동시키려고 하기 때문이다.

이 두 경우 모두 densification의 좋은 후보가 되므로, 저자들은 test에서 0.0002로 설정한 threshold τ_pos 이상의 view-space position gradients의 평균크기를 사용하여 Gaussian을 densify 한다.

재구성되지 않은 영역에 있는 작은 Gaussian의 경우 생성해야 하는 새로운 형상을 처리해야 한다. 이를 위해 동일한 크기의 복사본을 만들고 이를 position gradient 방향으로 이동하여 Gaussian을 복제하는 것이 좋다.

반면, 높은 분산을 가진 영역의 큰 gaussian은 더 작은 gaussian으로 분할되어야 한다. 이들은 이러한 guassian을 두 개의 새로운 gaussian으로 교체하고, 실험적으로 결정된 분할 계수 으로 크기를 나눈다. 또한, 원래 3D Gaussian을 sampling용 PDF로 사용하여 위치를 초기화한다.

1) Under-reconstruction 된 경우

우리가 목표로 하는 geometry 보다 Gaussain이 작은 경우 발생한다. 이때는 Gaussain을 clone 하게 되는데 우선 동일한 사이즈의 Guassian을 생성하고, positional gradient 방향으로 생성된 Guaissan을 이동시킨다. 이때, 총 부피와 Gaussain의 개수가 증가한다.

2) Over-reconstruction 된 경우

우리가 목표로 하는 geometry 보다 Gaussain이 큰 경우 발생한다. 이때는 Gaussian을 split 하게 되는데, 기존 Gaussain을 2개의 새로운 Gaussian으로 대체하고, 새로운 Gaussian의 위치는 기존 Gaussain을 샘플링하기 위한 확률 밀도함수(PDF)로 초기화된다. 이때, 총부피는 유지되고 Gaussain의 개수만 증가한다.

두 경우 모두 Gaussian의 수가 늘어나기 때문에 이를 the number of Gaussians를 적절히 조절하기 위해 N = 3000 일 때, 투명도를 0에 가까운 값으로 설정한다. Opimziation 과정을 통해서 𝛼 값은 계속 증가할 것이기 때문에, 𝛼 값을 주기적으로 줄여줌으로써 불필요한 Gaussain을 제거하는 것이다. 이는 quality 관점에서 floater를 제거하고 중복된 Gaussain을 제거하는 것과 같은 의미를 갖는다고 한다.

5. Fast Differentiable Rasterizer for Gaussians

본 논문에서 저자들의 목표는 빠른 rendering과 정렬을 통해 anisotropic splats를 포함한 approximate 𝛼-blending 을 구현하고, 제한된 splats 수에 의존하지 않고 gradients를 계산할 수 있도록 하는 것이다.

이를 위해, 저자들은 최근 software rasterization approaches에 영감을 받아, pixel 단위 정렬의 높은 계산 비용을 피하고 전체 이미지를 한 번에 처리하는 tile-based rasterizer for Gaussain splats 를 설계하였다. 이들의 fast rasterizer는 혼합된 Gaussain의 임의 개수에 대해 효율적인 역전파를 지원하며, 추가적인 memory 소비가 적고, 픽셀당 일정한 오버헤드만 필요로 한다. 이 rasterization pipeline은 완전히 미분 가능하며, 2D projection을 기반으로 anisotropic splats을 이전 2D splatting 방법과 유사하게 처리할 수 있다.

출처: https://dusruddl2.tistory.com/29 1) Cull Gaussain

https://velog.io/@gjghks950/3D-Gaussian-Splatting-%EC%99%84%EB%B2%BD-%EB%B6%84%EC%84%9D-feat.-CUDA-Rasterizer 카메라가 바라보는 영역인 view frustum에 없는 3D Gaussain을 모두 제거한다. 구체적으로, view frustum과 99% 신뢰 구간이 교차하는 Gaussain만 유지한다. 또한, 극단적인 위치에 있는 Gaussain (ex. view frustum 외부에 너무 멀리 있거나 가까운 평면 근처에 있는 경우)는 guard band를 사용해 제거한다. 이는 해당 Gaussain의 2D covariance projection을 계산하는 과정에서 불안정성을 방지하기 위함이다.

2) Screen Space Gaussain

출처: https://www.youtube.com/watch?v=Ncs5wOaetYg 3D Gaussain을 image plane을 projection 하여 2D Guassain을 얻는 과정이다.

이때, 3D Gaussain의 M(mean) and S(covariance) 뿐만 아니라 camera pose (V)까지 필요하다.

Projection을 통해 image plane에서 2D Gaussain의 M' and S'을 얻을 수 있다.

3) Create Time

출처: https://www.youtube.com/watch?v=Ncs5wOaetYg 이미지를 16 x 16 tile로 나눈다.

4) Duplicate with Keys

출처: https://www.youtube.com/watch?v=Ncs5wOaetYg 각 tile과 격치는 gaussian의 개수를 기반으로 instance를 생성하고, 각각의 instance에 view space depth와 tile ID를 결합한 key를 할당한다. 앞쪽 32bit는 depth 정보가 encoding 되고, 뒤쪽 32bit는 overlap 되어 tile의 index가 encoding 된다고 한다.

5) Sotred by Keys

이 key를 기반으로 GPU Radix 정렬을 사용해 Gaussain을 정렬한다.

6) Identify Tile Ranges

각각의 tile에 대해 깊이 순서로 정렬된 첫 번째와 마지막 항목을 식별하여 list를 생성한다.

7) Get Tile Range

Gaussain list를 읽어 온다.

8) Blend in Order

Rasterization을 위해 각 tile에 대해 하나의 thread block을 실행한다. 각 block은 먼저 Gaussain의 패킷을 공유 메모리에 공동으로 load 한 다음 지정된 픽셀에 대해 list를 앞뒤로 순회하여 생상과 α 값을 누적하므로 데이터 로드/공유 및 처리 모두에 대한 병렬 처리의 이득을 최대화한다. 픽셀에서 타겟 채도

Rasterization 중에는 α의 채도가 유일한 중지 기준이다. 이전 연구들과 달리 gradient update를 받는 blended primitves의 수를 제한하지 않는다. 저자들은 이 속성을 적용하여 장면별 hyperparameters tuning에 의존하지 않고 임의적이고 다양한 깊이의 복잡성이 있는 장면을 처리하고 정확하게 학습할 수 있도록 하였다. 따라서, backward pass 동안 forward pass에서 픽셀당 혼합된 point의 전체 sequence를 복구해야 한다.

이를 위한 한 가지 해결책은 global 메모리에 픽셀당 혼합된 point의 임의의 긴 list를 저장하는 것이다. 대신에 저자들은 동적 메모리 관리 오버헤드를 피하기 위해 타일별 list를 다시 탐색하도록 선택하였다. Forward pass에서 정렬된 Gaussian의 array와 타일 range를 재사용할 수 있다.

순회는 tile의 모든 pixel에 영향을 준 마지막 지점부터 시작되며 공유 메모리에 point를 다시 로드하는 작업이 공동으로 수행된다. 또한 각 pixel은 forward pass 중에 해당 색상에 기여한 마지막 point의 깊이보다 깊이가 낮거나 같은 경우에만 overlap test와 point 처리를 시작한다. Gradient 계산 시에는 원본 blending process 중 각 step에서 누적된 불투명도 값이 필요하다. Backward pass에서 점진적으로 줄어드는 불투명도의 list를 순회하는 대신 forward pass가 끝날 때 누적된 총 불투명도만 저장하여 이러한 중간 불투명도를 복구할 수 있다. 특히 각 포인트는 forward process에서 최종 누적 불투명도 α를 저장한다. 이를 뒤에서 앞으로 순회할 때 각 포인트의 α로 나누어 기울기 계산에 필요한 계수를 얻는다.

6. Exprimetns

- 다음은 이전 연구들과 본 논문의 방법을 정량적 및 시각적으로 비교한 표이다.

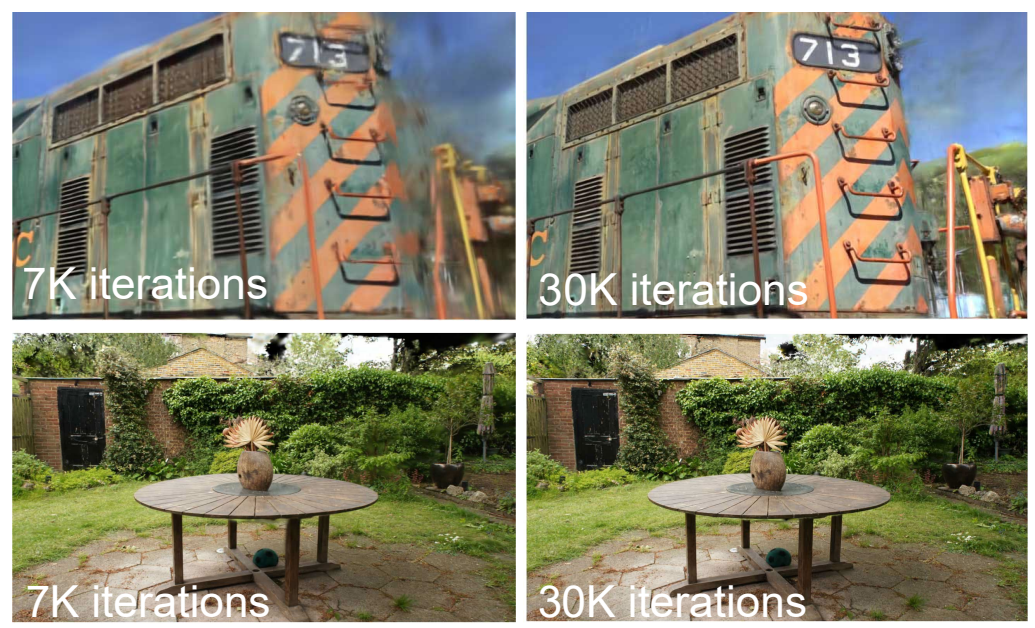

- 아래는 iteration 별 성능을 나타낸 것이다.

- 아래는 Albation study에 대한 성능 지표이다.

- SfM의 사용 유무에 따른 결과 비교

- Clone and split 전략의 유무에 따른 결과 비교

- 다음은 Gaussian 이방성을 비활성화하고 장면을 학습한 결과와 활성화하고 장면을 학습한 결과를 비교

3D graphics에 대한 지식이 부족해서, 다소 어렵다고 느낀 논문이었다. Neural Network를 사용하지 않고 진행을 한다는 것이 생소하였다. 코드 리뷰와 기초 이론 공부를 해서, 다시 한번 더 읽어봐야 할 논문인 것 같다.

래퍼런스

https://kimjy99.github.io/%EB%85%BC%EB%AC%B8%EB%A6%AC%EB%B7%B0/3d-gaussian-splatting/

[논문리뷰] 3D Gaussian Splatting for Real-Time Radiance Field Rendering

3D Gaussian Splatting 논문 리뷰 (SIGGRAPH 2023)

kimjy99.github.io

[논문 리뷰] 3D Gaussian Splatting (SIGGRAPH 2023) : 랜더링 속도/퀄리티 개선

3D Gaussian Splatting for Real-Time Radiance Field Rendering, Bernhard Kerbl, SIGGRAPH 2023 NeRF분야에서 뜨거운 이슈가 된 논문입니다. NeRF에서 해결하고자 하는 Task와 동일하게, 여러 이미지와 촬영 pose 값이 주어지

xoft.tistory.com

3D Gaussian Splatting for Real-Time Radiance Field Rendering 리뷰

3D Gaussian Splatting 리뷰

velog.io

https://dusruddl2.tistory.com/29

[Paper Review] 3D Gaussian Splatting for Real-Time Radiance Field Rendering (SIGGRAPH 2023)

3DGS를 처음 공부하시는 분들이라면 xoft님의 블로그와 유튜브 강의를 먼저 들으시는걸 추천드립니다.전체 알고리즘을 이해하기 쉽게 다뤄주시기 때문에 이해가 쉽습니다 :) 본 글은 논문을 순서

dusruddl2.tistory.com

https://www.youtube.com/watch?v=Ncs5wOaetYg

'AI > Vision' 카테고리의 다른 글

ReZero is All You Need: Fast Convergence at Large Depth (0) 2025.03.04 Fourier-based augmentation with applications to domain generalization (0) 2024.12.12 Bayesian Optimization Meets Self-Distillation (0) 2024.08.09 Get a Model! Model Hijacking Attack Against Machine Learning Models (0) 2024.08.07 DDPM: Denoising Diffusion Probabilistic Models (0) 2024.08.06